DeepSeek是一款基于AI技术的智能搜索引擎,结合深度学习与自然语言处理,提供精准、高效的搜索体验。探索DeepSeek,感受未来智能搜索的无限可能!

近年来,随着人工智能技术的飞速发展,算力成为推动AI模型训练和应用的重要基石。在此背景下,DeepSeek作为一款新兴的国产AI工具,正在逐步清晰化算力优化的路径,并为国内AI生态的闭环实现奠定基础。本文将深入探讨DeepSeek的核心功能、技术架构及其带来的变革,尤其关注其在算力成本、效率以及未来发展趋势等方面的意义。

DeepSeek的技术优势主要体现在对算力的极致优化。通过软硬件的协同创新,DeepSeek旨在实现国产算力性能的全面提升。上海交通大学的长聘教轨副教授戴国浩表示,DeepSeek不仅关注算法的精度,同时也注重系统的效率,这一思路的转变将推动大模型的训练和应用达到新的高度。模型训练通常需要庞大的算力支撑,而DeepSeek通过底层优化释放硬件性能,极大减轻了硬件对训练效率的制约。

DeepSeek的创新之处在于其底层硬件利用的优化。通过通信优化和内存优化,DeepSeek有效减少了传统AI训练中因资源利用不均而产生的低效问题。例如,DeepSeek提出的双向流水线机制,使得计算和通信几乎可以100%重叠,从而提升了模型训练的并行度。这种方法被认为是使用有限资源训练更大模型的有效策略,大幅提升了训练效率。

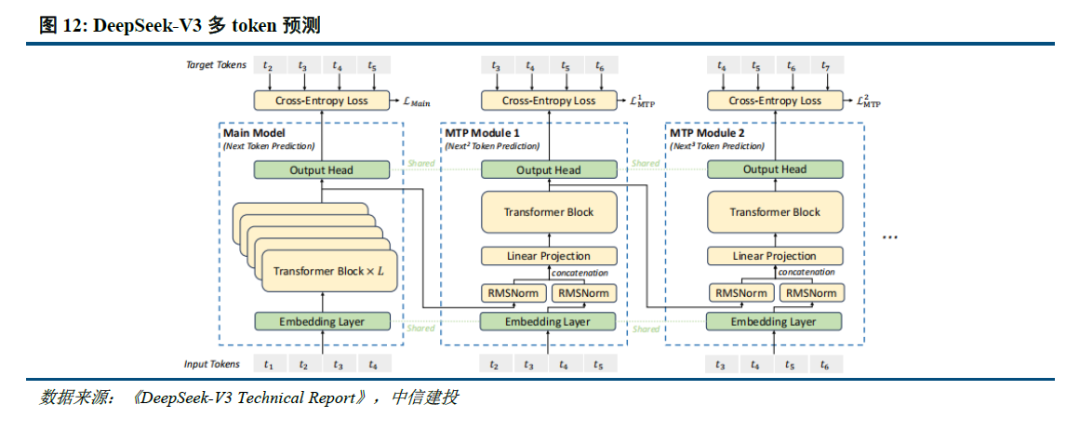

此外,DeepSeek在模型架构上也进行了突破。其采用的MLA(隐空间注意力计算机制)和MoE(混合专家模型)架构,极大降低了推理过程中的内存消耗。在MoE架构中,DeepSeek通过引入“专家偏见”的机制,实现了专家间的负载均衡,从而提高了集群的整体效率。这种设计不仅提升了模型的训练与推理能力,还在一定程度上降低了计算成本。

随着DeepSeek的技术不断推进,大家对未来算力的预期也在提升。据戴国浩分析,未来推理算力可能会有2-3个数量级的提升,而整体算力需求也会激增。尽管训练算力需求会继续增长,但DeepSeek提供的优化路径有望降低单位算力的获取成本,从而推动更广泛的应用场景落地。

DeepSeek的成功离不开对底层硬件及系统的深刻理解。戴国浩指出,使用传统的训练模型方法虽然简单,但在当今复杂的AI领域中,单纯依靠算法工程师已无法满足需求,反而需要对系统架构有深入的认识。这样的转变说明了AI研究与应用的一个新趋势:软硬件的紧密结合将成为推动技术进步的核心动力。

在国内AI行业,DeepSeek的出现被视为一次生态闭环的开端。过去,国产AI团队在算法准确性方面常常受制于国外技术的发展,而DeepSeek的优化路径则为国内提高算法竞争力提供了新的机遇。通过对模型的定制开发,国产AI技术也在逐步缩小与国际先进技术的差距。

中国的算力生态发展面临供需矛盾。虽然国产芯片种类繁多,基础设施健全,但在短期内却难以形成有效的闭环。DeepSeek通过高效的算力利用,尝试改变这种局面,为打造自我可控的AI生态提供了新的思路。未来,随着DeepSeek技术的不断进步,国产在算力领域的自主创新将进一步深化,推动整个AI行业迎来新的变革。

总结而言,DeepSeek不仅对优化算力路径起到至关重要的作用,也为国产AI生态的可持续发展提供了重要参考。在未来的AI发展中,如何实现算法、系统与硬件的深度协同,将是行业内团队必须面对的重要任务。通过深入理解底层技术,同时注重创新和优化,国产AI有望在全球市场中展现出更大的活力与竞争力。

在我使用了数十家AI绘画、AI生文工具后,强烈推荐给大家以下这个工具——简单AI。简单AI是搜狐旗下的全能型AI创作助手,包括AI绘画、文生图、图生图、AI文案、AI头像、AI素材、AI设计等。可一键生成创意美图,3步写出爆款文章。网站提供生成创意美图、动漫头像、种草笔记、爆款标题、活动方案等多项AI创作功能。工具链接: